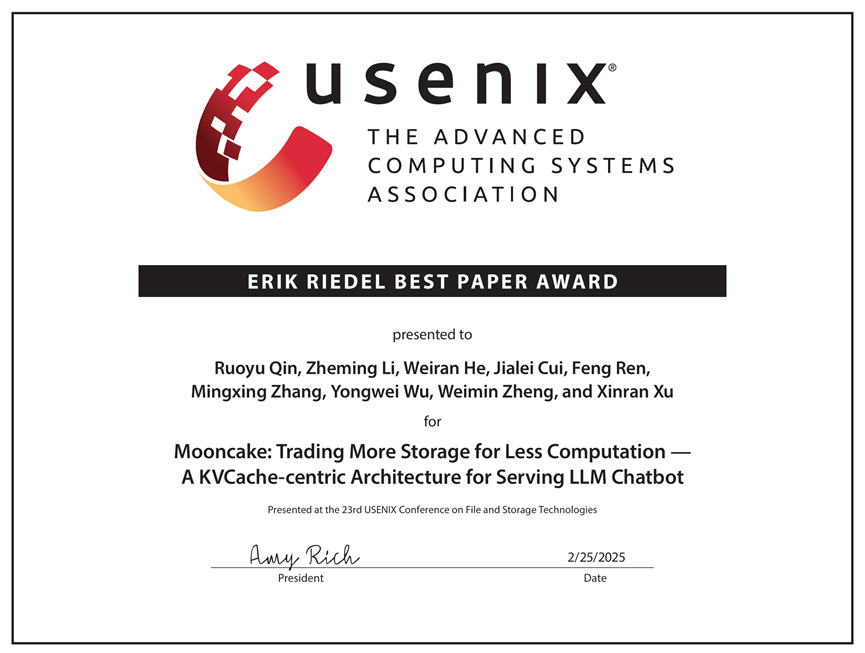

清華新聞網(wǎng)3月10日電 2月25日至27日,第23屆USENIX文件與存儲技術(shù)會(huì)議(USENIX Conference on File and Storage Technologies,FAST)在美國圣克拉拉舉行。計(jì)算機(jī)系教師章明星、武永衛(wèi)、鄭緯民團(tuán)隊(duì)和月之暗面公司合作發(fā)表的論文“以鍵值緩存為中心的以存換算大語言模型推理架構(gòu)”(Mooncake: Trading More Storage for Less Computation-A KVCache-centric Architecture for Serving LLM Chatbot)獲得埃里克·里德爾最佳論文獎(jiǎng)(Erik Riedel Best Paper Award)。論文的第一作者為計(jì)算機(jī)系博士生秦若愚,導(dǎo)師為助理教授章明星。

最佳論文獎(jiǎng)

該論文提出的系統(tǒng)Mooncake是月之暗面公司推出的大語言模型服務(wù)Kimi的底層推理服務(wù)平臺。Mooncake采用了一種以鍵值緩存(KVCache)為中心的分離架構(gòu),不僅將預(yù)填充和解碼集群分離,還高效利用了推理集群中未充分利用的CPU、DRAM、SSD和NIC資源,構(gòu)建了一個(gè)獨(dú)立的KVCache緩存池。其核心創(chuàng)新在于以KVCache為中心的全局緩存和調(diào)度器,旨在嚴(yán)格延遲相關(guān)服務(wù)級別目標(biāo)(SLOs)下最大化吞吐量。

實(shí)驗(yàn)結(jié)果顯示,Mooncake在處理長上下文輸入的場景中表現(xiàn)出色。在使用真實(shí)數(shù)據(jù)進(jìn)行的測試中,與基線方法相比,Mooncake在符合SLOs的情況下,將有效請求處理能力提升了59%至498%。目前,Mooncake已在數(shù)千個(gè)節(jié)點(diǎn)上運(yùn)行,每日處理超過1000億個(gè)token。在實(shí)際部署中,Mooncake的創(chuàng)新架構(gòu)使Kimi在NVIDIA A800和H800集群上分別比以前的系統(tǒng)多處理115%和107%的請求。

FAST(File and Storage Technologies)是計(jì)算機(jī)存儲領(lǐng)域的頂級學(xué)術(shù)會(huì)議,已創(chuàng)立二十余年,在存儲領(lǐng)域具有重要影響力,被中國計(jì)算機(jī)學(xué)會(huì)(CCF)認(rèn)定為存儲系統(tǒng)領(lǐng)域的A類國際學(xué)術(shù)會(huì)議。

供稿:計(jì)算機(jī)系

編輯:彭穩(wěn)平

審核:郭玲